GPT на языке бизнеса: особенности применения больших языковых моделей

Рассказывает Антон Чикин, руководитель отдела интеллектуального анализа центра машинного обучения «Инфосистемы Джет».

Теория больших языковых моделей

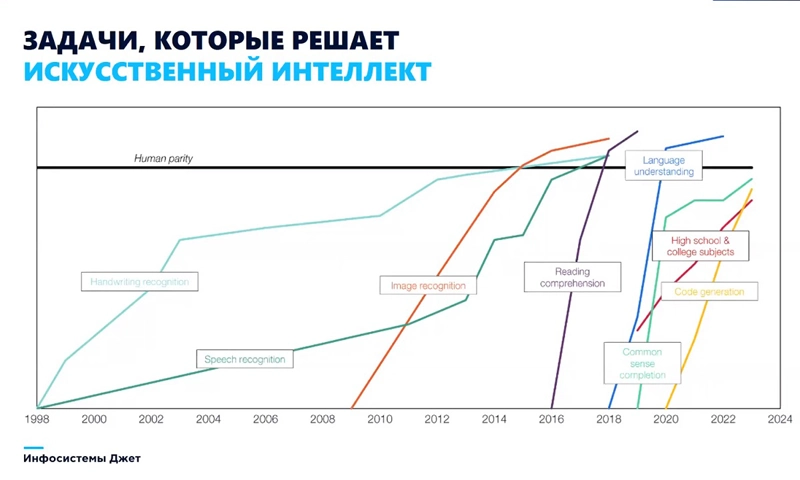

Чтобы наглядно объяснить историю применения технологий искусственного интеллекта, мы обратимся к графику, где черная горизонтальная линия условно обозначает интеллектуальные способности среднестатистического человека. Постепенно на исторической шкале появляются задачи, которые искусственный интеллект начинает решать эффективнее, чем человек: среди них – распознавание рукописного текста, речи и изображений, осмысленное чтение (reading comprehension), понимание языка, достройка до здравого смысла (common sense completion), генерация кода.

Эволюция AI в контексте выполняемых задач.

Источник: «Инфосистемы Джет»

На графике хорошо видно, что в начале 2010-х годов качество ML-моделей стало стремительно расти – в этот период как раз происходило развитие технологий глубокого обучения. А с 2017 года начали массово возникать новые направления их применения – это связано, в частности, с созданием первых GPT-моделей. Развитию технологий ML способствует также появление усовершенствованных систем хранения данных и мощных компьютеров. Сегодня мы уже умеем эффективно хранить большие массивы данных, а производители микроэлектроники ежегодно выпускают всё более производительные графические процессоры (GPU), а теперь уже и тензорные (TPU).

Разновидностью моделей машинного обучения является языковая модель – нейросеть, генерирующая распределение вероятностей по последовательностям слов в тексте на естественном языке. Проще говоря, на входе у модели – контекст, то есть некая последовательность слов, и ее задача – сгенерировать следующее слово или последовательность слов так, чтобы получился цельный, правдоподобный текст. Например, задав нейронной сети последовательность слов «кот» «сидит» «на», мы получаем на выходе фразу «кот сидит на коврике», что выглядит достаточно логично. Но откуда модель взяла этот коврик? И почему именно его, а не, например, диван?

Дело в том, что языковые модели генерируют вероятности путем обучения на корпусе текстов на одном или нескольких языках. Значит, перед тем, как задать ей вопрос, в ее базу данных загрузили некий текст, содержащий сведения про кота, сидящего на коврике.

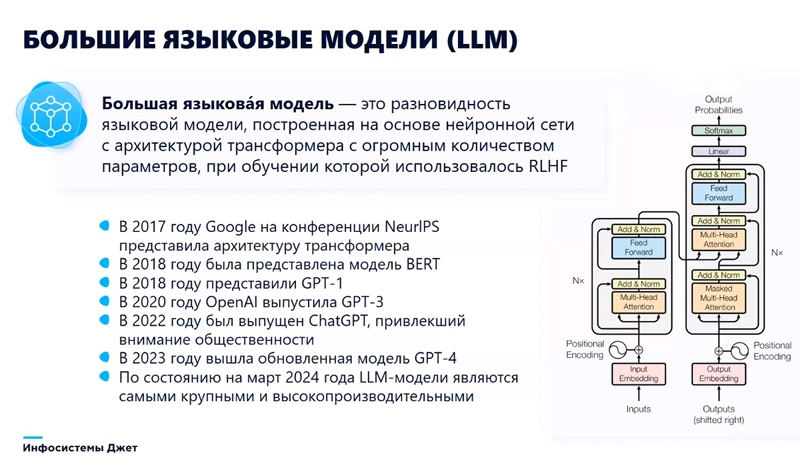

Большая языковая модель (LLM, large language model) отличается масштабом, архитектурой и методикой обучения: это разновидность языковой модели, построенная на основе нейронной сети с архитектурой трансформера с огромным количеством (миллиардами) взаимосвязанных параметров, при обучении которой используется метод RLHF (обучение с подкреплением).

История больших языковых моделей.

Источник: «Инфосистемы Джет»

На трансформерную архитектуру таких моделей указывает аббревиатура GPT, которая буквально означает generative pre-trained transformer – то есть генеративная предобученная модель-трансформер. Впервые такая архитектура была представлена исследователями Google в 2017 году на конференции NeurlPS. Уже в 2018 году на ее основе выходят модели BERT от Google и GPT-1 от OpenAI. В 2022 году произошел еще один технологический прорыв в этой области: OpenAI выпускает ChatGPT – интерфейс, позволяющий общаться с GPT не только программистам, но и обычным пользователям. В 2024 году выходит мультимодальная модель GPT-4o, которая в качестве контекста может принимать не только текст, но также аудио и изображения. Сегодня большие языковые модели LLM, являются самыми крупными и мощными моделями в мире.

Чтобы разработать большую языковую модель, нужны значительные инвестиции. Например, разработчикам модели LLaMA потребовалось загрузить в нее 10 ТБ информации из глобальной сети. Обучение происходило с помощью 6000 графических ускорителей на протяжении 12 дней и стоило компании около 2 млн долларов. Результатом этого труда стал файл «parameters.zip» объемом 140 ГБ, который в сжатом упорядоченном виде содержит всю загруженную в модель информацию.

К счастью, теперь компаниям, желающим воспользоваться большими языковыми моделями, уже не нужно тратить столько ресурсов. Разработчики LLM предоставляют доступ к своим моделям всем желающим за небольшую плату. Более того – каждая компания имеет возможность дообучить базовую модель на собственных данных, чтобы адаптировать ее к конкретной задаче. Помимо уже упомянутого ChatGPT, на российском рынке лидерами в этом сегменте являются локальные игроки – Яндекс (YandexGPT), Сбер (GigaChat) и МТС (MTS AI Chat).

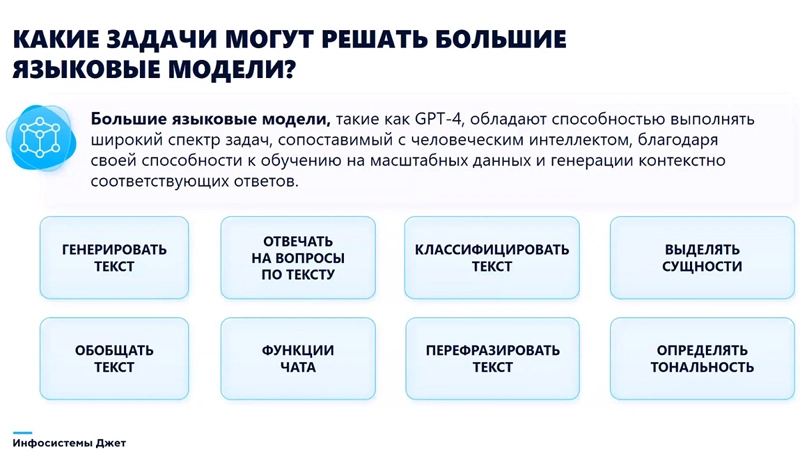

Возможности и ограничения LLM

Большие языковые модели, как ChatGPT, обладают способностью выполнять широкий спектр задач благодаря своей способности к обучению на масштабных данных и генерации контекстно соответствующих ответов. В частности, они умеют генерировать текст, классифицировать и обобщать его, выделять главную мысль, отвечать на вопросы по тексту. Например, если нам нужно найти в огромном документе имена, фамилии или другую информацию, сформулировать смысл текста в нескольких тезисах, – языковые модели могут в этом хорошо помочь.

Возможности больших языковых моделей.

Источник: «Инфосистемы Джет»

Если нам нужно переработать уже имеющийся текст, чтобы получить уникальный материал, – это тоже простая задача для нейросети. Большие языковые модели могут не только пересказывать текст «своими словами», но и изменять его стилистику.

Современные LLM имеют функцию чата – это означает, что при каждом новом запросе вам не нужно постоянно напоминать ей контекст беседы, то, о чем вы уже успели поговорить.

Можно сказать, что современные большие языковые модели умеют делать с текстом всё то же самое, что умеет среднестатистический человек. Соответственно, и сценариев применения в бизнесе у них достаточно много.

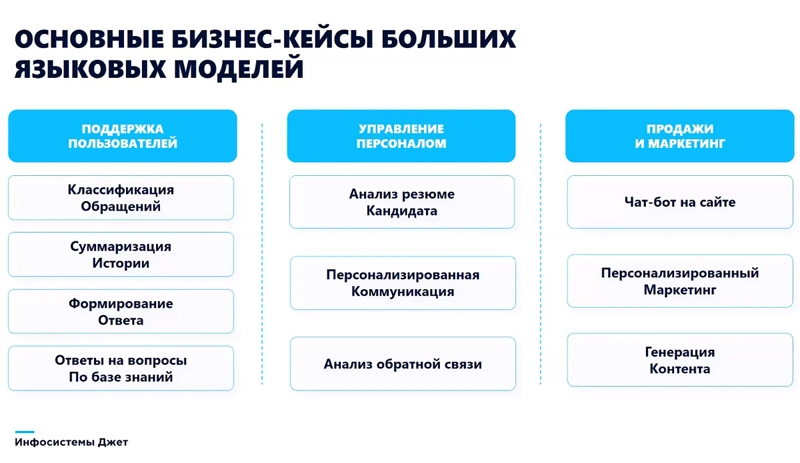

Сценарии применения больших языковых моделей.

Источник: «Инфосистемы Джет»

Первая сфера их применения – продажи и маркетинг, а именно всем известные чат-боты на веб-сайтах и в мобильных приложениях.

Вторая сфера – генерация самого разного контента: новостей, инструкций и т. п.

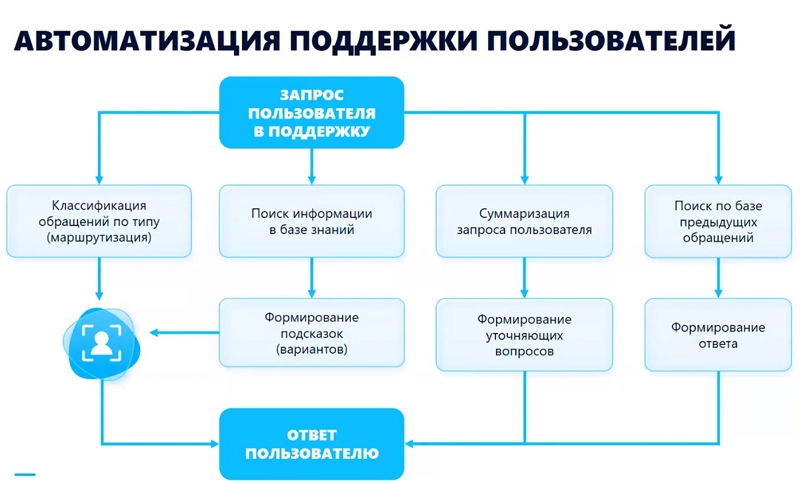

Третья, более конкретная сфера – поддержка пользователей. В каждой компании обработка пользовательских заявок в службу поддержки является важным бизнес-процессом, от которого зависит эффективность ее деятельности. Например, если сотрудник испытывает проблемы с оборудованием или доступом к рабочему месту, он не может выполнять свои должностные обязанности, и его работа останавливается. Поток заявок от пользователей на стороне сервис-деска превращается в очередь, обрабатывать которую нужно как можно быстрее. Большие языковые модели позволяют упростить этот этап.

Четвертая сфера – управление персоналом. Если в компании появилась интересная вакансия, на которую претендуют сотни соискателей, специалисту HR необходимо просмотреть каждое резюме, чтобы не пропустить наиболее подходящего кандидата. Большие языковые модели помогают автоматически просмотреть все резюме, подготовить краткую выжимку по ним и провести первичный отбор, выделив резюме, не соответствующие требованиям работодателя.

Пятая сфера – функции секретаря. На дистанционных встречах с коллегами или партнерами зачастую необходимо вести протокол, чтобы потом, например, сформировать перечень утвержденных задач, ответственных исполнителей и сроков. Большие языковые модели могут расшифровать текст собрания, разобрать его по спикерам, сделать выжимку по каждому спикеру, зафиксировать, какие проблемы обсуждались, какие задачи и сроки были запланированы.

Применение больших языковых моделей уже сегодня достаточно широкое, а в перспективе количество таких сценариев будет только расти. Они позволяют быстро обработать текст, освободив сотрудников от однотипных рутинных и затратных по времени задач.

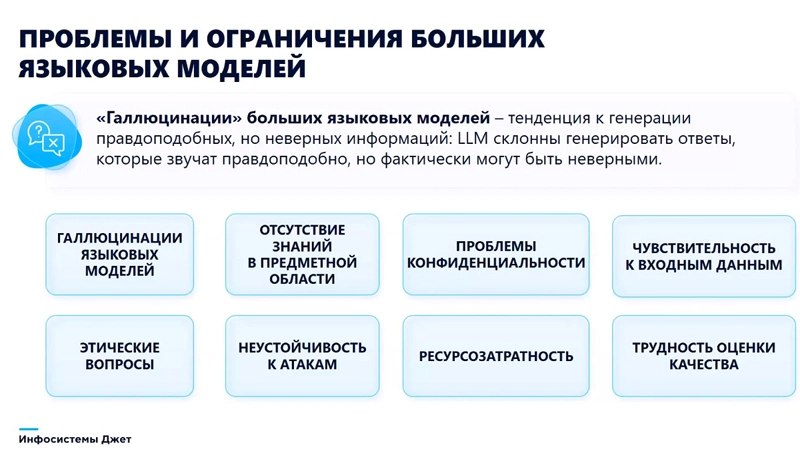

Ограничения больших языковых моделей.

Источник: «Инфосистемы Джет»

Вместе с тем и ограничений LLM пока остается достаточно много.

Первый существенный недостаток языковых моделей – «галлюцинации», то есть тенденция к генерации очень правдоподобных, но по сути неверных текстов. Это происходит, когда в базе знаний модели отсутствует информация по определенной узкой предметной области, но какой-то ответ она предоставить все равно должна.

Из других проблем наиболее важная – проблема конфиденциальности. Если в компании принято решение дообучить большую языковую модель на собственных данных, эти данные обязательно должны быть обезличенные – иначе есть большой риск их утечки.

Также, чтобы эффективно использовать большую языковую модель, в компании потребуется перестроить бизнес-процессы и подготовить необходимую инфраструктуру: это могут быть облачные вычислительные ресурсы или собственный сервер с графическим ускорителем, если компания работает с конфиденциальными данными и желает сохранить их в периметре.

Наконец, существуют сложности с оценкой качества работы языковых моделей. Если для оценки выполнения других задач в компании выработаны вполне понятные бизнес-метрики, то в случае обработки текстов для определения эффективности модели должны привлекаться профильные специалисты.

Эксперт: руководитель отдела интеллектуального анализа

центра машинного обучения «Инфосистемы Джет» Антон Чикин.

Источник: «Инфосистемы Джет»

Языковые модели в сервисном центре «Инфосистемы Джет»

Сервисный центр компании «Инфосистемы Джет» оказывает широкий спектр услуг: от ИТ-аутсорсинга до технической поддержки внутренних пользователей. Специалисты центра машинного обучения компании проанализировали заявки внутренних клиентов сервисного центра и изучили возможности использования современных языковых моделей для автоматизации рутинных операций.

Сначала были классифицированы обращения пользователей, относящиеся к области ИТ, по их типу. Это могут быть, например, сообщения о том, что у пользователя не работает электронная почта, не открывается бизнес-приложение или отсутствует звук на компьютере. Классификатор обращений позволил настроить их автоматическую маршрутизацию профильным специалистам. Этот подход даже не потребовал использования больших языковых моделей – были применены более простые алгоритмы, – но позволил значительно сократить время отклика техподдержки: обращения теперь не скапливаются в очереди и быстрее попадают к нужному специалисту.

Варианты применения LLM в центре технической поддержки.

Источник: «Инфосистемы Джет»

На следующем этапе были проанализированы исторические данные: специалисты изучили длинный перечень вопросов и ответов службы поддержки и сформировали базу из примерно сотни типовых, эталонных кейсов. Теперь с помощью метода, основанного на векторном представлении и сравнении текстов, система ищет для каждого нового обращения похожие запросы в этой базе и при их наличии – подсказывает оператору сервисного центра вариант ответа. Это уже более продвинутый подход, который в идеале позволил бы вообще не привлекать специалиста к обработке обращения. Такое возможно в случаях, когда пользователю требуется консультация или готовая инструкция: например, о том, как установить приложение или как подключиться к конференции. Но пока это работает только на ограниченном наборе ситуаций.

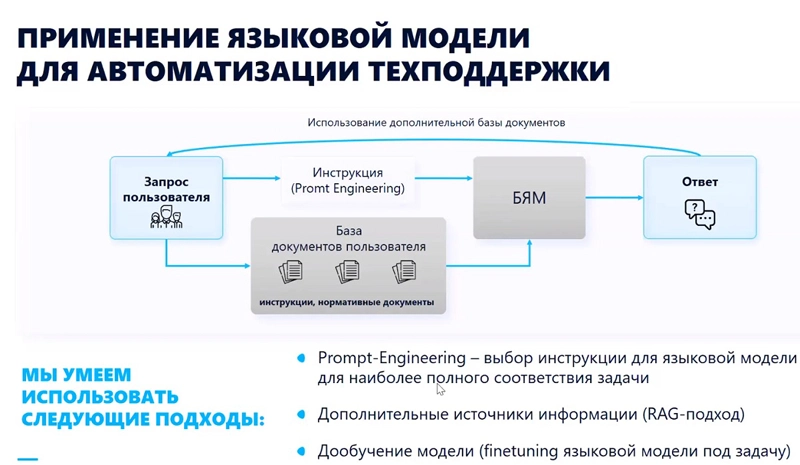

Далее компания перешла к еще более сложному кейсу, который уже в полной мере позволяет использовать языковые модели. Он основан на методе RAG (Retrieval Augmented Generation) – генерации модели с включением в контекст дополнительных уточняющих запросов. Для этого использовалась вторая база знаний – с документами, описывающими разные ситуации, возникающие в процессе оказания поддержки пользователям: в частности, инструкции операторов сервисного центра и техническая документация к информационным системам. Эти документы были проиндексированы, распределены по десяти тематикам и стали доступны для поисковых алгоритмов. Теперь, когда в систему поступает новый запрос, который нельзя классифицировать в рамках типовых случаев, она ищет во второй базе по ключевым словам похожие темы, формирует перечень релевантных документов и отдает готовый набор на вход нейросети. Вопрос (промт) к языковой модели строится таким образом, чтобы она генерировала ответ на основании полученных документов из базы знаний. Языковая модель успешно справляется с частью таких запросов и так же, как прошлая, позволяет сократить время сотрудника поддержки на поиск ответа.

Взаимодействие LLM с базой документов.

Источник: «Инфосистемы Джет»

Таким образом, сегодня в сервисном центре компании «Инфосистемы Джет» в пилотном режиме эксплуатируется цифровой ассистент специалиста службы поддержки, использующий два основных подхода: базу типовых вопросов и ответов и базу знаний. Интересно, что этот инструмент может подключаться к разным языковым моделям – open source решениям и вендорским сервисам от Яндекса, Сбера и других разработчиков.

По итогам обработки в системе около 13 тыс запросов оказалось, что в среднем 20-30% из них могут быть автоматизированы, то есть пользователь может получить грамотный ответ полностью без участия оператора.

При этом точно классифицированы по 100 утвержденным эталонным темам могут быть 75% запросов – то есть в большинстве случаев система точно понимает, какую проблему хочет решить пользователь. Для тех ответов, которые формируются по базе дополнительной документации, языковые модели могут в 80% случаях дать корректный ответ.

Результаты пилотирования LLM в сервисном центре.

Источник: «Инфосистемы Джет»

Специалисты центра машинного обучения «Инфосистемы Джет» тестируют и другие наработки, связанные с применением языковых моделей: в частности, суммаризацию истории общения с пользователем, когда оператор поддержки при получении очередной заявки видит все более ранние обращения, проблемы и их решения. Еще один интересный перспективный сценарий – автоматическая генерация с помощью языковой модели уточняющих вопросов к пользователю по теме исходного обращения.

Мы пришли к выводу, что автоматизация работы сервисного центра на основе больших языковых моделей позволяет специалистам службы поддержки быстрее реагировать на заявки и на 20% сократить время на обработку типовых запросов. Снижение доли рутинной работы дает им возможность сконцентрироваться на более сложных или творческих задачах.

Свежее по теме

Интересные ссылки

- «Мостострой-11» в три раза сократил расходы на SaaS-сервисы благодаря переходу на Яндекс 360 для бизнеса

- «Национальная компьютерная корпорация» представила новое направление для промышленной автоматизации ─ реинжиниринг АСУТП

- Т1 ИИ импортозамеcтит решения класса БДРВ в системах управления производством

- Компании «АйТи Бастион» и «Базис» успешно завершили интеграцию продуктов

Об экспертности спикера

Отдел интеллектуального анализа центра машинного обучения «Инфосистемы Джет» занимается разработкой и внедрением моделей машинного обучения, алгоритмов оптимизации и планирования, подхода MLOps в пайплайн. Подразделение создает модели машинного обучения на основе классических табличных данных и технологий цифрового зрения, а также на основе больших языковых моделей.