Selectel провела разработчиков по «MLечному пути»

23 апреля 2025 года на площадке Selectel на Цветочной, 19 прошел митап, посвященный кейсам и технологиям в сфере машинного обучения, — «MLечный путь – 2025: знания, опыт, комьюнити». Мероприятие проходило одновременно в двух форматах: очно и онлайн, чтобы те, кто не смог приехать в Петербург, также приняли в нем участие. Митап вызвал большой интерес профессионального сообщества: собрался практически полный зал, после каждого доклада звучали вопросы не только от присутствующих, но и от онлайн-зрителей. Авторы самых интересных вопросов получили симпатичных плюшевых тирексов — маскотов компании Selectel.

Чуть поредевшая стая тирексов – призы для авторов лучших вопросов

Фото: Елизавета Клейн / ICT-Online.ru

Подбор инфраструктуры для ML

DevOps-инженер Selectel Антон Алексеев рассказал о тактике подбора инфраструктуры для ML под разные бизнес-запросы на примере реальных кейсов. Отдел Data/ML-продуктов Selectel осуществляет разработку решений на основе инфраструктуры собственного облака для клиентов, которые занимаются обучением моделей и экспериментируют с ними.

DevOps-инженер Selectel Антон Алексеев с тирексом – символом Selectel

Фото: Клейн Елизавета / ICT-Online.ru

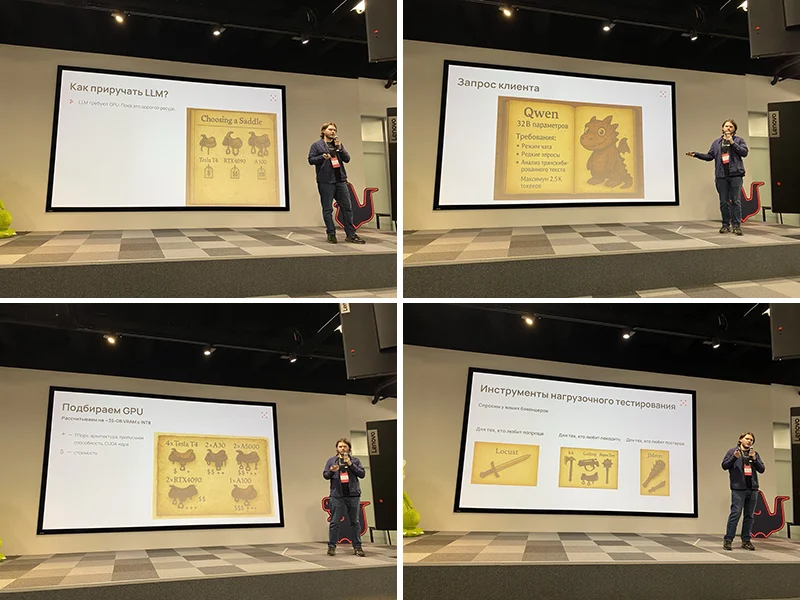

В своем докладе спикер сравнил LLM (Large Language Model, большие языковые модели) с драконами, и сопроводил презентацию соответствующими иллюстрациями с драконами, викингами, седлами для драконов и различными типами оружия.

В качестве первого шага при развертывании моделей, по словам Антона Алексеева, клиенты часто используют популярное направление System Design, позволяющее рассчитать необходимые значения для CPU, RAM и диска на основе введенных требований в виде метрик RPS (Requests Per Second), месячных активных пользователей и задержки (Latency).

Для работы LLM требуются мощные видеокарты – этот фактор существенно чувствительнее к ошибкам в расчетах. Спикер подробно объяснил, как выявлять необходимые значения, дал ссылку на калькулятор для расчетов, рассказал о том, как ведет себя инференс (вывод результатов работы обученной модели – прим. ред.) на разных видеокартах, о фреймворках инференса и о конфигурации инференса vLLM.

Были перечислены также инструменты нагрузочного тестирования: Locust, K6, Gatling, Яндекс.Танк, JMeter, Perf Analyzer и GenAI Perf. Поговорили и о выборе подходящей квантизации (процесс преобразования числовых значений в модели – прим. ред.) — разница может достигать 4,5 раз, также спикер сравнил бэкенды для LLM: Triton и Tensor RT LLM.

У компании есть планы на автоматизацию подбора инфраструктуры, включить подбор выделенных физических серверов под AI, а также использовать в Inference PaaS и foundation models.

Кадры из презентации DevOps-инженер Selectel Антона Алексеева

Источник: трансляция митапа «MLечный путь – 2025: знания, опыт, комьюнити» на сайте Selectel

В конце своего доклада Антон Алексеев оставил ссылки на канал, посвященный подбору ML-инфраструктуры, а также на канал «MLечный путь» — сообщество ML и MLOps-инженеров, организованное Selectel, насчитывающее более 3,5 тыс. участников.

Оптимизация инференса в GPU

Продуктовый лидер Cloud.ru в направлении Evolution ML Inference Артемий Мазаев рассказал о возможностях экономии ресурсов GPU в условиях облака.

По словам спикера, подавляющее большинство пользователей неэффективно используют свои GPU-карты. Из исследования, проведенного Cloud.ru среди клиентов, стало известно, что фактически у них занято менее 50% графических процессоров. Это происходит вследствие SMS-подхода (single model serving) к выделению: на одну модель выделяется одна GPU-карта. Использование MMS-подхода (multi-model serving) позволяет осуществлять оптимальное распределение GPU-карт на модели.

Продуктовый лидер Cloud.ru в направлении Evolution ML Inference Артемий Мазаев

Фото: Клейн Елизавета / ICT-Online.ru

Для второго подхода ранее использовалась технология Model Manager, предоставляющая инсталляции глобальных фреймворков. В этом случае распределение моделей между картами GPU производится планировщиком в зависимости от свободных ресурсов. Но данный подход не дает тонкой изоляции между картами, и при «падении» той или иной модели вместе с картой остальные модели, привязанные к этой карте, также «упадут».

Избежать такой ситуации позволяет VLM-продакшн, представленный в 2024 году на одной из последних конференций VLM. Благодаря ему можно «на лету» добавлять LoRA-адаптеры к текущей модели. У продукта есть встроенный планировщик всех имеющихся моделей, а также удобный KV-кэш, распределенный по всем нодам всех виртуальных машин. Подход MMS требует большего количества служебных операций и сервисов, поэтому SMS-подход облегчает горизонтальное масштабирование, однако при MMS подходе масштабирование может быть вертикальным и более экономным.

В своем выступлении Артемий Мазаев сравнил подходы к инференсу, обозначил принципы выделения GPU-карт, подробно осветил SMS- и MMS-подходы, рассказал, как выбрать способ нарезки GPU, осветил аспекты перехода на vGPU, предоставил результаты тестирования, а также рассказал об областях применения.

Инференс в экстремальных условиях

Технический директор и кофаундер компании Цельс Женя Никитин рассказал об уровнях сложности инференса в зависимости от условий использования на примерах применения ML-моделей в сфере здравоохранения, отличающейся повышенными требованиями в области безопасности, приватности персональных данных.

Технический директор и кофаундер компании Цельс Женя Никитин

кадр из трансляции мит-апа

Именно повышенные требования к инфобезу являются зачастую причиной, по которой заказчики не готовы размещать ресурсы в облачных сервисах, хотя именно этот уровень является наиболее простым: его использует примерно половина всех клиентов компании, преимущественно москвичи. Облачный подход, по словам спикера, обеспечивает максимальное масштабирование ресурсов, возможность деплоя сервисов на разные ресурсы, автоматического масштабирования ресурсов с учетом роста и падения нагрузки в разное время суток, а также легкое обновление моделей. Не возникает проблем у заказчика и с «железом», а также с мониторингом.

Второй уровень сложности определяется необходимостью размещать ресурсы на физических машинах, как обычно делают в регионах. Ключевая сложность в том, что после написания ТЗ и проведения закупки оборудования может обнаружиться нехватка ресурсов из-за попыток сэкономить или просчетов при планировании.

В этом случае иногда помогает оптимизация моделей, переход на новую версию PyTorch, снижение размеров входных изображений. Обновления требуют приостановки работы систем, идеально в данном случае использовать автоматизацию, например, скрипты для запуска обновлений ночью, а также автоматизировать проверку корректности работы установленных обновлений. Для мониторинга лучше использовать инструменты баз данных: для PostgreSQL спикер порекомендовал Foreign tables и View с объединением данных из нужных регионов.

Еще один аспект работы с регионами – неправильно настроенные правила маршрутизации, приводящие к появлению «мусора» во входных данных. С этим можно справиться, добавив модуль фильтрации, классифицирующий исследования как брак или как не брак по набору критериев.

Наивысший уровень сложности — подвижные конструкции: медицинские поезда, передвижные маммографы и т.д. В этом случае масштабирование невозможно, поэтому необходимо очень строго подходить к формированию технического задания, по возможности закладывая дополнительные ресурсы под возможные обновления.

Критически важным становится возможность самовосстановления системы, поскольку мониторинг практически невозможен – появляется необходимость в большом количестве health-check (проверок работоспособности — прим. ред.), необходимо сохранение логов и загрузка их на удаленный сервер при каждом наличии интернет-соединения, а также отдельная кнопка для перезагрузки всей системы.

Развертывание видеоаналитики для комбайнов

Senior-разработчик Русагро Тех Адель Самигуллин рассказал об опыте развертывания видеоаналитики в агротехнических проектах. Так, среди ранее реализованных проектов есть роботизированные устройства, позволяющие проводить мониторинг большого количества загонов для животных с использованием тепловизора и камеры. С помощью них можно не только оценивать чистоту загонов для животных, но и обнаруживать в них забытые посторонние предметы, осуществлять подсчет животных в каждом из загонов, выявлять наиболее комфортные зоны, излюбленные животными, а также находить больных животных благодаря выявлению особей с повышенной температурой тела. Также в Русагро Тех есть проекты с применением статичных камер, подсчитывающих, сколько свиней прошло или проехало по определенной зоне.

Senior-разработчик Русагро Тех Адель Самигуллин

Фото: Елизавета Клейн / ICT-Online.ru

Однако основной темой доклада стала видеоаналитика работы зерноуборочных комбайнов, позволяющая мониторить в режиме реального времени весь процесс, начиная от сбора сельскохозяйственной культуры с поля и заканчивая ее отгрузкой в хранилище.

Использование датчиков не всегда возможно, поскольку часть сельхозтехники компании является арендованной, и хозяева редко разрешают встраивать в нее сложные устройства, а простые не годятся из-за большого количества потенциальных ложных срабатываний.

В процессе разработки решения главными вопросами стали необходимость отбора полезных видеоотрезков среди огромного объема неинформативных видеозаписей, выбор портативных вычислительных устройств в условиях трудностей с импортом техники, а также выбор нейронной сети.

В итоге всю систему удалось разместить в отдельном ящике, который крепится к кабине комбайна, к нему прикрепляются две камеры, одна из которых направлена на жатку комбайна, а вторая — на шнек, из которого высыпается урожай.

За несколько недель использования таких устройств на нескольких комбайнах компания собрала около полутора тысяч часов видеоданных. Было необходимо вычленить из них информативные моменты — с движением самого комбайна или высыпанием зерна.

В первом случае брали два последовательных кадра и прогоняли их через алгоритм Template matching, который накладывал один кадр на другой: различие кадров в большей части случаев означало, что комбайн движется.

Во втором задача ставилась как обнаружение выдвинутого шнека, поскольку он выдвигается только в те моменты, когда осуществляется отгрузка. Для решения задачи брались кадры из видео, обрезались примерно по той области, где будет потенциально выдвинут шнек, и отправлялись в DINO v2 — энкодер-трансформер, обученный в Self-Supervised режиме — он хорошо справляется с построением векторов представления изображений без какого-либо дополнительного обучения.

В результате задача была сведена к metric learning, где векторные представления изображений близки друг к другу, если эти изображения похожи друг на друга. В результате можно было брать несколько референсных фрагментов кадров с выдвинутым шнеком и подсчитать similarity score между первым фрагментом и референсами. Если similarity score достаточно высокий, там потенциально находится выдвинутый шнек и эти данные нужно забрать на ручную аннотацию. Использование этих алгоритмов позволило сократить количество данных для обучения в девять раз.

Питч-сессия

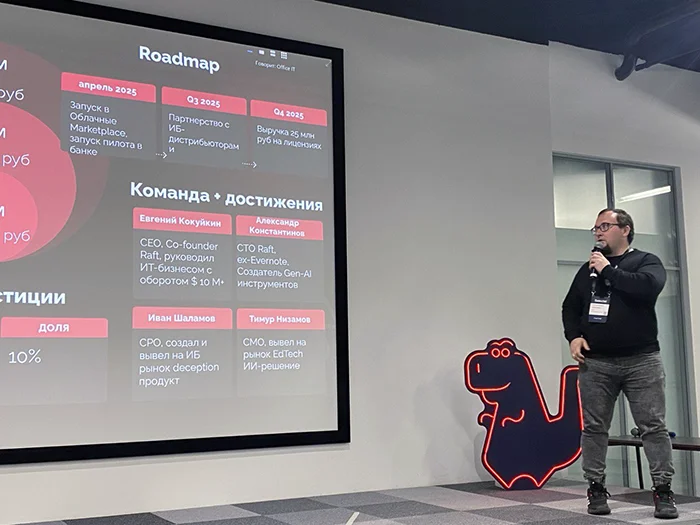

Встреча завершилась презентацией pet-проектов. Участникам давалось три минуты на представление своего проекта, после чего запускалось зрительское онлайн-голосование. Среди проектов были представлены AI-помощник Ева (стартап “Ударник”), которая умеет собирать контакты потенциальных клиентов и автоматически связываться с ними; мультимодальный ИИ «вИИзуал», анализирующий каждый кадр и фото в Data Lake; продукт HiveTrace, обеспечивающий безопасность внедрения генеративного ИИ в клиентские продукты за счет постоянного мониторинга и эффективной защиты от атак; Lissa Health — продукт, который позволяет на основе данных находить различные отклонения от нормы — начиная от диагностирования заболеваний и заканчивая контролем качества работы лабораторий или обнаружения риска экологических катастроф; проект Volga на базе движка для вычисления ML фичей в режиме реального времени.

Автор проекта-победителя Александр Константинов

фото: Елизавета Клейн / ICT-Online.ru

Каждый голосующий мог выбрать два понравившихся ему проекта и проголосовать за них в течение отведенных трех минут. Победителями, набравшими наибольшее количество голосов, стали авторы проектов HiveTrace, Volga и «вИИзуал». Они получили бонусные баллы для использования облачных сервисов Selectel.

Свежее по теме

Интересные ссылки

- ИИ в управлении B2B-продажами: бизнес ускоряет сделки и снижает риски

- В Юнион доступен новый функционал: интеграция с телефонией MANGO OFFICE, подсказки от «Хинтед» и конфиденциальные вакансии

- Облачный провайдер ActiveCloud (ГК Softline) помог сети салонов керамической плитки мигрировать на облачный почтовый сервис SmartMail

- АО «ГЛОНАСС» переходит на Astra Linux нового поколения

- ГК Softline и «ОБИТ» объявляют о стратегическом сотрудничестве в области импортозамещения